8 noviembre, 2023

8 noviembre, 2023

Inteligencia Artificial Generativa

La Inteligencia Artificial Generativa (IAG) es una rama de la inteligencia artificial que se enfoca en la generación de contenido original a partir de datos existentes. Esta tecnología utiliza algoritmos y redes neuronales avanzadas para aprender de textos e imágenes, y luego generar contenido nuevo y único. Los avances en la IAG han sido impresionantes en los últimos años, […]

7 noviembre, 2023

7 noviembre, 2023

Beneficios de Tecnología emergente

¿Sabías que el estudio “Impulsar la adopción de tecnologías emergentes en América Latina” reveló que el tema de la #TransformaciónDigital ha cambiado de un “vamos a esperar” a un “vamos a probar”?, ¡pues se han dado cuenta del potencial que tiene para sus negocios!De hecho 90% de las compañías aumentará su inversión en tecnologías emergentes […]

2 enero, 2023

2 enero, 2023

Tendencia en las industrias

Del vapor al sensor (contexto histórico). Primera revolución industrial La primera revolución industrial ayudó a permitir la producción en masa mediante el uso de energía hidráulica y de vapor en lugar de energía puramente humana y animal. Los productos finales se construyeron con máquinas en lugar de producirlos minuciosamente a mano. Segunda revolución industrial En […]

12 diciembre, 2022

12 diciembre, 2022

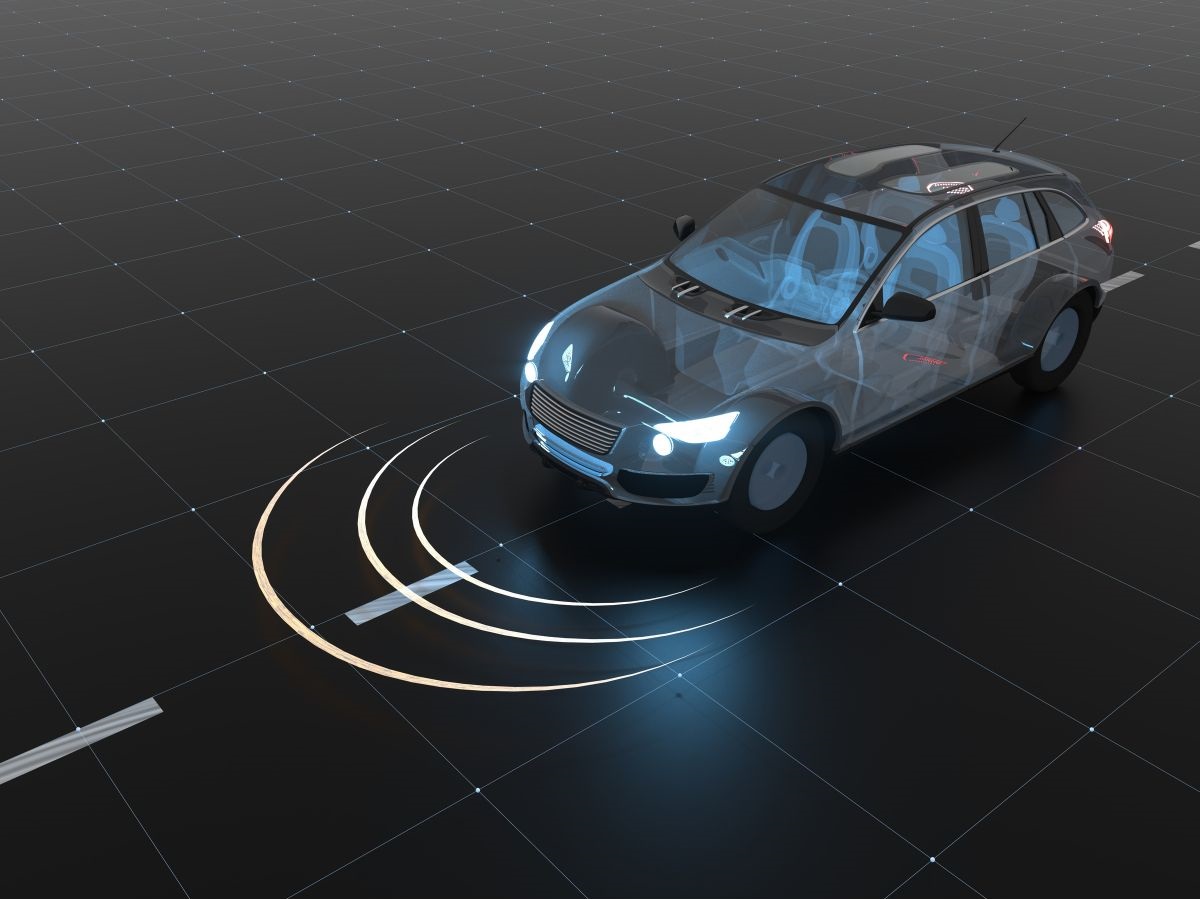

Falta talento en tecnologías para vehículos autónomos.

En la actualidad, en las calles de Las Vegas, Nevada, y Phoenix, Arizona, en Estados Unidos, o de Beijing, en China, los autos autónomos son una realidad. Lyft, compañía estadounidense de movilidad que ha instalado uno de sus mayores centros de desarrollo en México, decidió desplegar sus primeras flotillas de vehículos autónomos en las ciudades […]

12 diciembre, 2022

12 diciembre, 2022

Aumenta el dominio de la Realidad Aumentada e Inteligencia artificial en soluciones al alcance del mundo.

Sony presentó tecnologías que conectan a la perfección lo virtual y lo físico en su evento de intercambio de tecnología que está abierto al público por primera vez. Sony presenta un especial interés por la Realidad Aumentada (RA), así como por lo que concierne al mundo virtual. «Feria de Intercambio Tecnológico de Sony (STEF)» Dado […]

Inteligencia Artificial – El poder de las máquinas.

Este contenido está restringido a suscriptores

El IoT y la Inteligencia Artificial lograrán cero defectos en la producción industrial

Este contenido está restringido a suscriptores

Diseñan y ensayan un dron para salvar vidas en el Mediterráneo

Este contenido está restringido a suscriptores

Las oportunidades del internet de las cosas para este año

Este contenido está restringido a suscriptores

La inteligencia artificial, nueva aliada de la medicina en China

Este contenido está restringido a suscriptores

Translatotron: el “robot” de Google que puede traducir en directo la voz a otro idioma, sin usar texto.

Este contenido está restringido a suscriptores

La inteligencia artificial llega a 700 escuelas en Bélgica

Este contenido está restringido a suscriptores

Thalon, el robot colombiano que le llevará la comida hasta su habitación

Este contenido está restringido a suscriptores

El futuro compañero de trabajo se llamará cobot.

Este contenido está restringido a suscriptores

La versión web de Word prepara un corrector hipervitaminado, gracias a la IA que nos asesorará sobre cómo mejorar nuestros documentos

Este contenido está restringido a suscriptores

Crean un traductor que convierte las señales cerebrales en frases.

Este contenido está restringido a suscriptores

Inteligencia artificial para evitar que nos inunde la basura

Este contenido está restringido a suscriptores

La realidad aumentada complementará a los asistentes de voz

Este contenido está restringido a suscriptores

Predecir el cáncer de mama 5 años antes de que aparezca, posible gracias a la IA

Este contenido está restringido a suscriptores

Google abre el primer laboratorio de inteligencia artificial de África

Este contenido está restringido a suscriptores

La IA aprende a cultivar albahaca, para hacer pesto aún más sabroso

Este contenido está restringido a suscriptores

Inteligencia Artificial, una nueva forma de hacer música

Este contenido está restringido a suscriptores

Huawei lanza app que permitirá detectar discapacidad visual en niños

Este contenido está restringido a suscriptores

Las contraseñas del futuro serán nuestros cuerpos.

Este contenido está restringido a suscriptores

La inteligencia artificial no puede impartir Justicia.

Este contenido está restringido a suscriptores

Primer Instituto de Inteligencia Artificial centrada en el ser humano

Este contenido está restringido a suscriptores

GAFAS INTELIGENTES QUE AUTORREGULAN LA GRADUACIÓN.

Este contenido está restringido a suscriptores

La tecnología, herramienta clave para renovar un modelo educativo

Este contenido está restringido a suscriptores

PRESENTAN ROBOTS ASISTENTES PARA LOS JUEGOS OLÍMPICOS DE TOKIO 2020.

Este contenido está restringido a suscriptores

La India usa inteligencia artificial para combatir la ceguera diabética

Este contenido está restringido a suscriptores

Innovaciones que transformaran la industria alimentaria en cinco años

Este contenido está restringido a suscriptores

Robots que trabajan con humanos para Amazon, un anticipo del futuro.

Este contenido está restringido a suscriptores

Cloud Query permite que firewalls ATP detecten malware antes de que se propague.

Este contenido está restringido a suscriptores

Desarrollan Software que escribiría noticias automáticamente.

Este contenido está restringido a suscriptores

Crean silla de ruedas con IA que se controla con el rostro

Este contenido está restringido a suscriptores

CES 2019: Se presentó un horno con realidad aumentada que enseña a cocinar

Este contenido está restringido a suscriptores

Chatbot AIRe, el asistente inteligente que te ayuda a reciclar

Este contenido está restringido a suscriptores

Google y Edebé se alían para mejorar la educación con la inteligencia artificial y Big Data.

Este contenido está restringido a suscriptores

Inteligencia Artificial que crea campaña de forma inteligente pensada en Pymes

Este contenido está restringido a suscriptores

Usan reconocimiento facial para localizar niños extraviados.

Este contenido está restringido a suscriptores

Move Mirror, el nuevo experimento de Google que compara tus movimientos con miles de imágenes en tiempo real.

Este contenido está restringido a suscriptores

Robot con IA llegará más allá de la exosfera.

Este contenido está restringido a suscriptores